"Dark Web ChatGPT" - Is your data safe?

Ulubiony na świecie chatbot AI znalazł niesamowitą różnorodność przypadków użycia od czasu jego publicznego udostępnienia 8 miesięcy temu. Było tylko kwestią czasu, zanim hakerzy wykorzystają tę moc do własnych celów. Z doniesień o Dark Web ChatGPT na wolności, jak bardzo jesteśmy bezpieczni?

Jaka jest nazwa „Dark Web ChatGPT”?

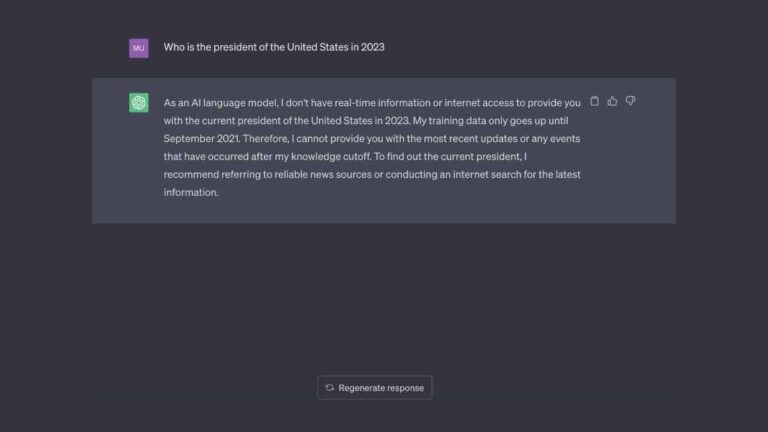

WormGPT, „czarna alternatywa” dla ChatGPT, szybko zyskuje popularność na tajnych forach ciemnej sieci. W terminologii hakerskiej hacking whitehat odnosi się do legalnego i jawnego działania polegającego na niewłaściwym używaniu oprogramowania do wykrywania usterek przed złymi aktorami, zwykle finansowanego przez firmę, która je stworzyła. Hakowanie Blackhat jest celowe iz definicji szkodliwe dla tej firmy. Wypróbuj „Co to jest ChatGPT – i do czego służy?” lub „Jak use ChatGPT na urządzeniach mobilnych”, aby dowiedzieć się więcej o ChatGPT.

Do czego służy „Dark Web ChatGPT”?

Szkodliwe działania cyberprzestępców pozornie nie znają granic. Wiemy natomiast, że zalety modelu LLM (Large Language Model), takiego jak bot czatu OpenAI, sprzyjają oszustwom tożsamości, atakom typu phishing, oszustwom związanym z inżynierią społeczną i pisaniu kodu złośliwego oprogramowania. W niedawnym poście na blogu Daniel Kelley z firmy zajmującej się bezpieczeństwem cybernetycznym Slashnext wyjaśnia: „Postęp technologii sztucznej inteligencji (AI), takich jak ChatGPT OpenAI, wprowadził nowy wektor ataków na służbową pocztę e-mail (BEC). Umożliwiając automatyzację „wysoce przekonujących fałszywych wiadomości e-mail, spersonalizowanych pod kątem odbiorcy”, przestępca znacznie zwiększa swoje szanse na udane oszustwo.

Jak zauważa Dmitrij Szestakow, szef ds. wywiadu w Group-IB: „Biorąc pod uwagę, że standardowa konfiguracja ChatGPT zachowuje wszystkie konwersacje, może to nieumyślnie zaoferować podmiotom zajmującym się zagrożeniami skarbnicę poufnych danych wywiadowczych, jeśli uzyskają dane uwierzytelniające konta”.

Co więcej, „zdolność ChatGPT do tworzenia bardzo autentycznych tekstów na podstawie podpowiedzi użytkownika sprawia, że jest to niezwykle przydatne narzędzie do phishingu” ostrzega europejski organ ścigania Europol.

Czy zhakowane konta ChatGPT są sprzedawane w ciemnej sieci?

Firma Group-IB zajmująca się cyberbezpieczeństwem potwierdziła, że od czerwca 2022 r 100 000 danych logowania użytkowników ChatGPT wyciekło na ciemne rynki internetowe. Region Azji i Pacyfiku (Indie i Pakistan) zajmuje pierwsze miejsce na liście najbardziej zagrożonych kont, a następnie Brazylia, Wietnam, Egipt, Stany Zjednoczone, Francja, Indonezja, Maroko i Bangladesz. Użytkownicy we wszystkich regionach powinni podjąć kroki w celu dalszej ochrony swoich urządzeń.

Nazwa złośliwego oprogramowania, które umożliwiło tę kradzież danych, to Raccoon Infostealer. Dobrą wiadomością jest to, że twoje dane uwierzytelniające ChatGPT zostaną naruszone tylko wtedy, gdy pobierzesz to oprogramowanie przez e-mail. Zła wiadomość jest taka, że złodzieje informacji (Vidar i Redline również przyczyniły się do tego naruszenia danych) stały się znacznie bardziej rozpowszechnione i łatwe do stworzenia w ciągu ostatniego roku.

Jak możesz chronić się przed oszustwami AI?

Bezpieczeństwo haseł jest ważniejsze niż kiedykolwiek. Najlepszą praktyką dla użytkowników dowolnej sztucznej inteligencji (Microsoft Bing, Google Bard, OpenAI’s ChatGPT itp.) jest używanie różnych, silnych haseł do każdej witryny i usługi. Aby to ułatwić, wielu użytkowników sieci zezwala swojej przeglądarce na zapamiętywanie haseł, ponieważ realistycznie nikt nie ma takiej pamięci, aby osiągnąć to bez pomocy.

Niestety stwarza to słaby punkt między pobieraniem z serwera a przesyłaniem danych, w którym dane logowania do konta istnieją w plikach cookie przeglądarki. Ten słaby punkt można nawet wykorzystać w oszustwach związanych z kryptowalutami, w których podstawowa technologia blockchain jest bezbłędna, ale sposób uzyskiwania do niej dostępu może nie być. Rozważ uwierzytelnianie dwuskładnikowe w dowolnej witrynie lub usłudze, na której naprawdę Ci zależy. Shestakov z Group-IB dochodzi do wniosku, że skrobanie danych było realistycznie wynikiem „złośliwego oprogramowania towarowego na urządzeniach ludzi, a nie naruszenia OpenAI”.

Nie należy również przesyłać żadnych poufnych informacji do modelu języka AI. Naukowcy znaleźli dowody na istnienie firm AI z wykorzystaniem danych przesłanych przez użytkownika z monitów o szkolenie swoich LLM. W rezultacie firmy, w tym Google, ostrzegają swoich pracowników, aby nigdy nie przesyłali poufnych danych w monicie chatbota.

It will certainly interest you:

- Gmail's serial correspondence in 2023: the definitive guide This is a complete guide to serial mailing from Gmail in...

- ChatGPT or Bing chatbot? Which chatbot AI is best for you? I've been using ChatGPT Ever since OpenAI launched the software in 2022, it's been...

- ChatGPT: How to use the AI chatbot everyone is talking about By now you've probably heard of ChatGPT, a prototype of a general chatbot....

- What is ChatGPT? - What is it used for? ChatGPT is an AI Chatbot developed by Open Artificial Intelligence. Chatbot...